Apple рассказала, как ее система сканирования фотографий защищена от злоупотреблений

Apple признала, что то, как она объявила о своих планах по автоматическому сканированию библиотек фотографий iPhone для защиты детей от оскорбительного контента, могло внести "путаницу" и объяснить, как это разработано для предотвращения злоупотреблений со стороны авторитарных правительств.

После некоторых горячих отзывов от сообщества в целом, похоже, что Apple признала, что внесла "путаницу" в свое первоначальное объявление, и выпустила обновленный документ о своем плане сканирования фотографий на предмет материалов о сексуальном насилии над детьми (CSAM) на iPhone пользователей, iPad и других устройств Apple.

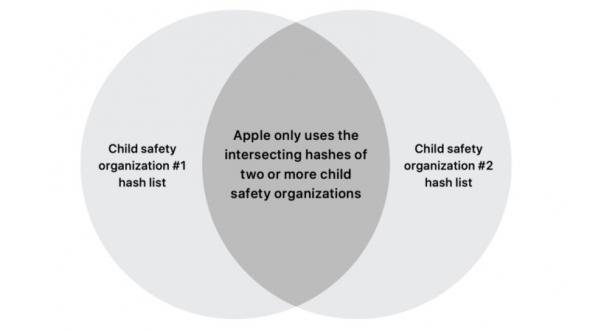

Согласно обновленному документу, Apple надеется развеять любые опасения по поводу конфиденциальности и безопасности, связанные с развертыванием, заявив, что не будет полагаться на единую государственную базу данных для идентификации CSAM. Вместо этого он будет сопоставлять только изображения как минимум двух групп с разной национальной принадлежностью.

Этот план предназначен для того, чтобы одно правительство не могло тайно вставлять несвязанный контент в целях цензуры, поскольку хэши не будут совпадать с другими в объединенных базах данных. Сегодня утром исполнительный директор Apple Крейг Федериги обрисовал в общих чертах ключевую информацию этого плана в интервью The Wall Street Journal.

Хотя эта концепция теоретически хороша, она должна защитить детей от хищников, но эксперты по конфиденциальности и криптографии разделили резкую критику плана Apple.

Ранее компания заявляла, что система будет использовать несколько баз данных о безопасности детей, но до сегодняшнего утра не было объяснения, как эти системы будут работать и как они будут перекрываться. Согласно комментариям Федериги, они все еще дорабатывают соглашения с другими группами по защите детей, и только Национальный центр по делам пропавших без вести и эксплуатируемых детей (NCMEC) в США официально назван и является частью программы.

В документе также объясняется, что после того, как что-то было помечено базой данных, вторая "защита" - это проверка человеком, когда Apple должна визуально подтверждать все положительные совпадения хэшей программ как содержащие материалы CSAM, прежде чем Apple отключит учетную запись и файл. отчет в организацию по безопасности детей.

В документе содержатся дополнительные сведения о том, как Apple будет отмечать учетную запись iCloud только в том случае, если она определила 30 или более изображений как CSAM (порог, установленный для обеспечения "резкого запаса прочности" (стр. 10), чтобы избежать любых шансов ложных срабатываний. система встает на место и начинает использоваться в реальном мире, Федериги сказал, что этот порог может быть изменен и адаптирован. Apple также предоставит полный список хэшей, которые аудиторы используют для проверки баз данных безопасности детей в качестве дополнительного шага на пути к полной прозрачность, чтобы гарантировать, что это не "тайное" сопоставление - читайте: цензура - больше изображений.

Apple также отметила, что не намерена менять свои планы по развертыванию системы сканирования фотографий этой осенью.

Для тех, кто заинтересован, полный текст статьи от Apple доступен для чтения здесь.